1.3 KiB

1.3 KiB

Policy Gradient

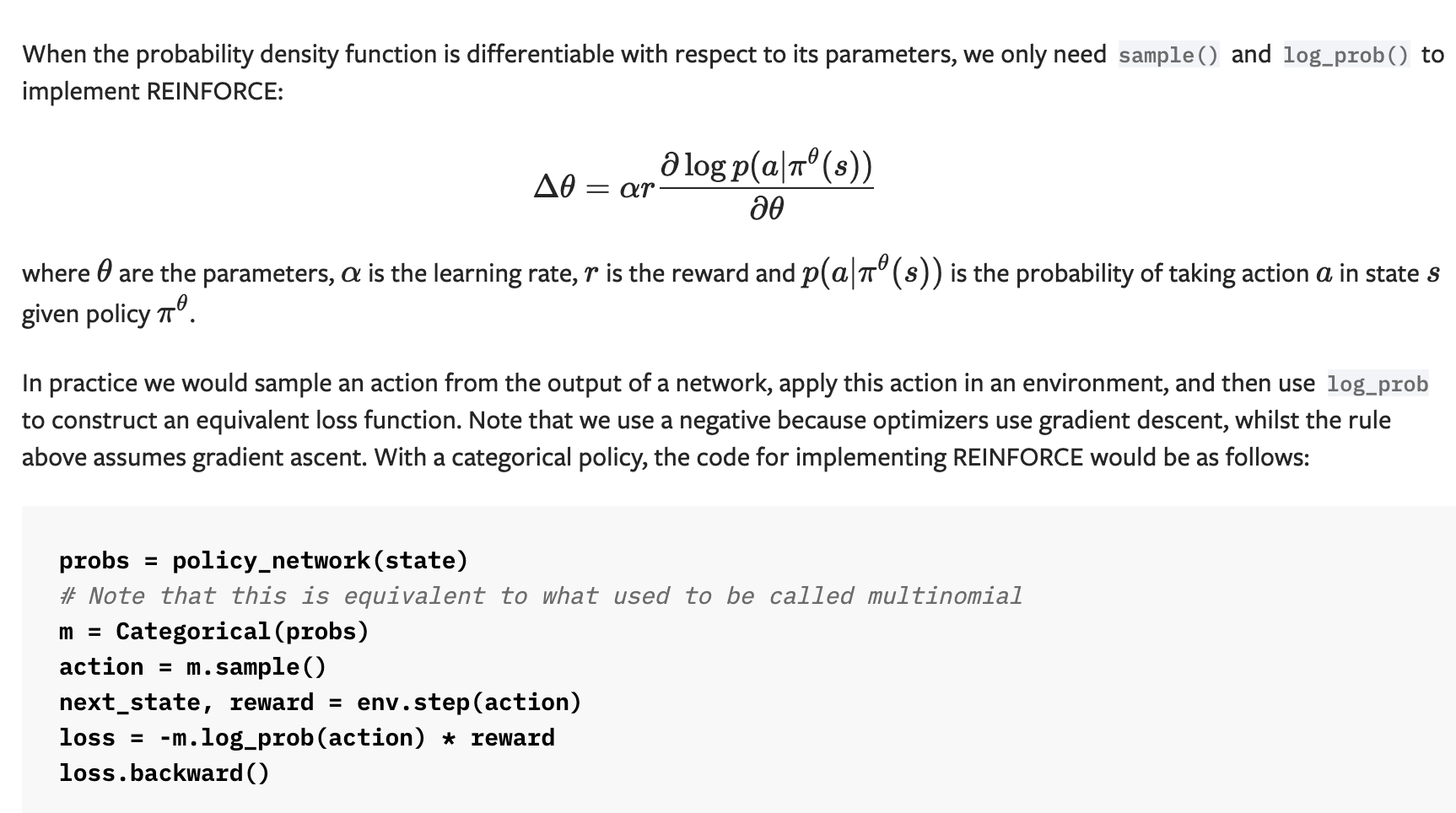

Policy-based方法是强化学习中与Value-based(比如Q-learning)相对的方法,其目的是对策略本身进行梯度下降,相关基础知识参考Datawhale-Policy Gradient。 其中REINFORCE是一个最基本的Policy Gradient方法,主要解决策略梯度无法直接计算的问题,具体原理参考CSDN-REINFORCE和Reparameterization Trick

伪代码

结合REINFORCE原理,其伪代码如下:

https://pytorch.org/docs/stable/distributions.html

加负号的原因是,在公式中应该是实现的梯度上升算法,而loss一般使用随机梯度下降的,所以加个负号保持一致性。